Welcome to MyBlog!

本文所以截图以及文字均来自于:Coursera

1. softmax回归

有一种更普遍的逻辑回归的方法叫做softmax回归 这种方法能够让你试图预测一个 多种分类中的类别时做出预测,而不是识别两类中的类别

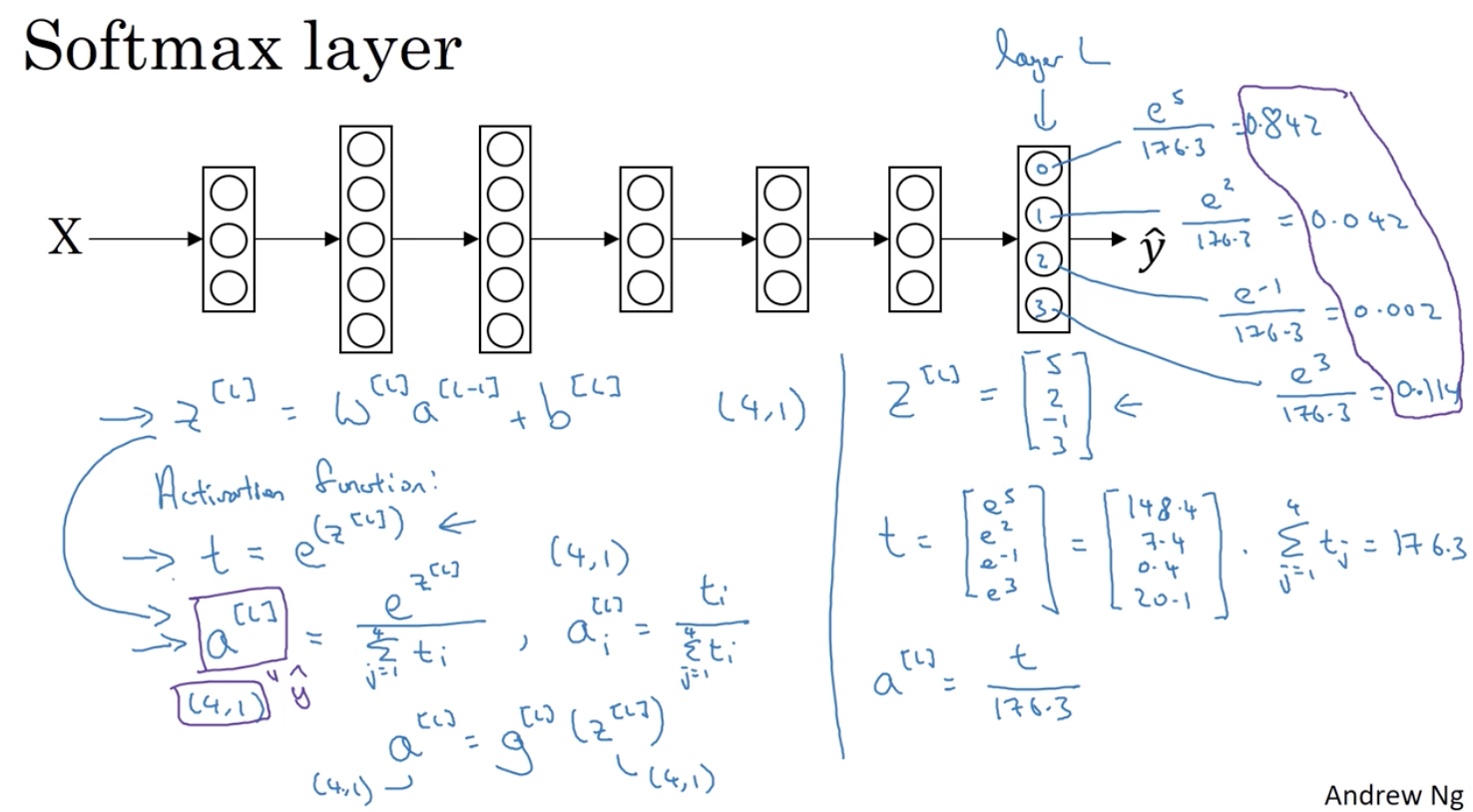

以前我们的激活通常是接收单行输入 比如 sigmoid函数和ReLU函数就是接收一个实数输入 然后输出一个实数的输出 softmax函数的不同之处就是 由于它需要把输出归一化 以及输入输出都是向量

2. 如何训练一个带有softmax层的神经网络

hardmax:将矢量z映射到这个矢量 即 hardmax函数遍历Z中的元素 将Z中最大的元素对应的位置置1 其余位置置0 所以它实在简单粗暴(hard) 最大的元素得到输出1 其余的元素对应输出0 与之相对的是 softmax中Z到这些概率值的映射要平和些 所以 我不知道这是不是一个NB的名字 但是至少它体现了softmax背后的直观原因

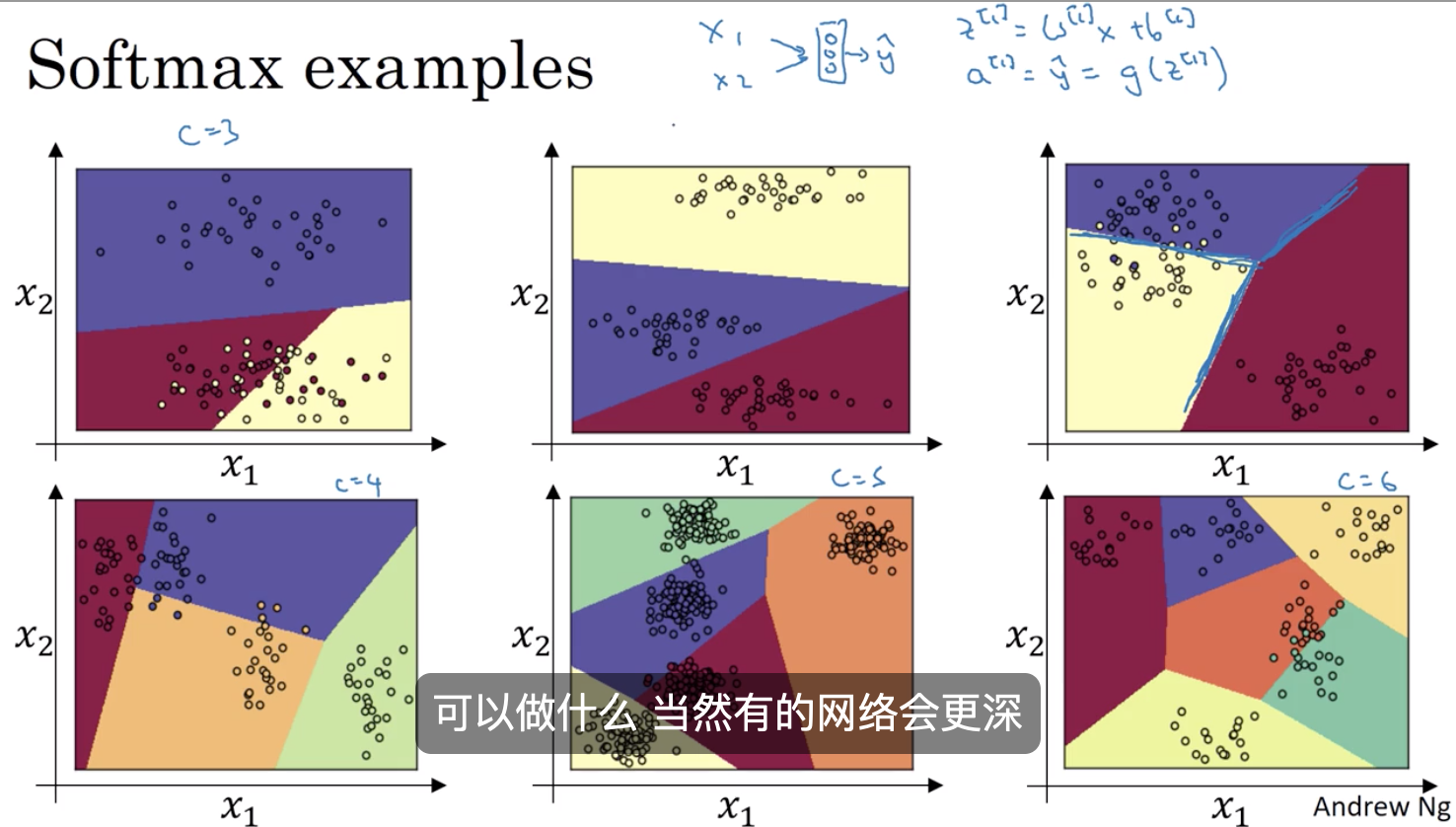

softmax激活函数将logistic激活函数 从2分类推广到C分类 也就是说 如果C=2 那么C=2的softmax 实际上将简化成logistic回归